grok-银河app下载安装

自一个月前xbench公布第 一期leaderboard以来,ai大模型界又迎来了新一轮的“你追我赶”。

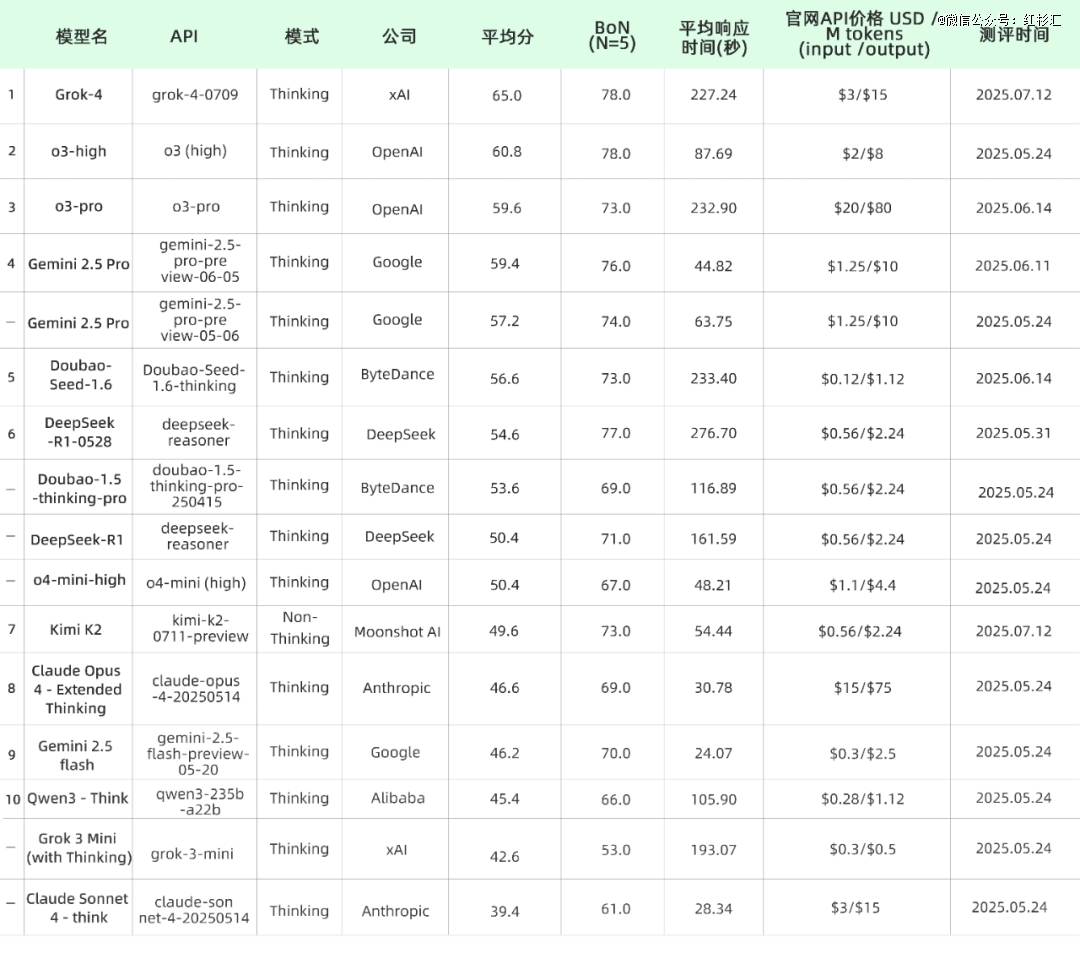

上周,xai发布了“全球最强大的”grok-4,两天后,kimi推出并开源了“一万亿参数”的k2模型。xbench对这两个“新玩家”火速进行了测评,并发布新一期双轨评估体系agi进程(agi tracking)系列的科学问题解答测评集(xbench-scienceqa)榜单。

science-qaleaderboard更新

备注:

汇率取1usd=7.1491cny

本次评估基本涵盖了截至排行榜发布之日主流大语言模型的公开可用应用程序编程接口(apis),未公开发布的内测模型未列入榜单。

如果一家公司有多个模型,优先测试最新版本和官方网站推荐的模型。所有模型均关闭搜索功能。

一家公司有多个模型时,排名中保留每家公司的最新模型版本。当同一推理模型存在不同的推理成本时,仅保留得分最高的版本。

榜单含thinking和non-thinking模式,未区分成两个榜单,榜单前10中kimi k2为non-thinking模型,其余均为thinking模型。

截止于2025年7月14日,与5月26日发布的leaderboard相比,有6家模型发布的版本更新进入前10:

grok-4:grok-4相比同为推理模型的前作grok-3-mini,在scienceqa评测集上实现了42.6分至65.0分的巨大提升,提升了约50%。grok-4超越了openai的o3模型,成为scienceqa评测集上的sota模型。

o3-pro:openai o3-pro版本在scienceqa评测集上达到59.6分,比o3的54.4分有一定提升,与o3(high)的60.8分相近。但模型的响应时间变长、api价格增加。

gemini 2.5 pro 0605:相比于同一模型的前序0506版本,价格不变,性能小幅提升到59.4分。

doubao seed 1.6:相比于seed的前一版本seed-1.5-pro,分数从53.6提升至56.6,同时相比1.5版本api价格下降约50%。

deepseek r1-0528:相比r1的前一版本,scienceqa分数由50.4提升至54.6。

kimi k2:最新的kimi k2模型在scienceqa中得分49.6,在榜单中位于non-thinking模型第 一,bon分数为73.0,位居头部梯队。

在此测评集中,对来自16家公司的43个不同版本的模型进行了测试。模型得分的分布情况如下:

整体变化:xai的grok-4登顶sota、moonshot ai的kimi k2进入前10,openai、google、bytedance、deepseek、anthropic等厂商的主流模型在xbench-scienceqa榜单上的偏序和此前保持一致。

模型性能对比

下图的横轴为api输出价格,纵轴为xbench-scienceqa平均分。

高质高价区:grok-4、o3-pro、gemini 2.5 pro处于右上方,分数领 先但成本也显著较高。grok-4有更好的表现,且输出价格$15只有o3-pro的1/4不到,在同档模型中最 具竞争力。

性价比区:doubao-seed-1.6在保持56.6分高分的同时,输出价格只需$1.1。与deepseek-r1同属于最 具性价比的模型。

响应速度对比

下图的横轴为平均响应时间,纵轴为xbench-scienceqa平均分。

深度推理模型:推理模型整体表现出推理时间越长,分数越高的趋势。grok-4分数最高,平均回复时间也是最长的一档。gemini 2.5 pro在保持高分(59.4)的同时,平均回复时间不到50s,接近非推理模型,在性能和延时上做到了最 佳的平衡。

模型成本对比

下图的横轴为api价格,纵轴为xbench-scienceqa的bon得分(n=5)。

bon 作为多步推理正确率指标,比平均分更直接反映模型在长链条任务中的潜在上限,可用来评估其作为agent底座时能够达到的上限。

grok-4与o3-high以bon=78并列总体第 一,其次是deepseek-r1-0528与gemini 2.5 pro 0605(76),但是deepseek的成本要显著更低。

在国产模型阵营里,在deepseek居首,doubao-seed-1.6与kimi k2(均73)并列第二,成本在同一区间,为开发者选择国产模型搭建复杂agent时提供了更多的参考。

月度新模型和产品总结

grok-4

grok-4与grok-4 heavy是xai于7月10日发布的全新推理模型,rl阶段使用了其前代grok-3十倍的算力投入,获得了显著的智能飞跃。从基础版grok-4,到支持原生工具调用的版本,再到思考阶段引入了多智能体协作模块的grok-4 heavy,均横扫了人类前沿科学领域的各个榜单(aime/gpqa/livecodebench/...),并在象征着人类专家级别最困难的智能基准测试humanity's last exam中取得了前所未有的突破。

grok-4在预训练过程中即融入了原生tool use能力,并在rl阶段注入了与预训练相当的算力,追求从“第 一性原理”出发推导因果。在思考阶段,grok-4引入了网页实时检索帮助事实判断,并设计了由多个不同智能体平行思考协作的分布式推理模块,并验证了这种test-time scaling在模型智能提取上的有效性。

kimi k2

kimi k2是moonshot ai于7月11日发布的开源权重moe模型,高达1t的总参数量,32b的激活参数量,384个专家的超稀疏结构,是迄今为止最 大的开源模型。发布的版本中包含纯基座模型kimi k2-base与基于指令微调的kimi k2-instruct,两者均为未经过rl强化学习训练的非思考模型。但均已展现出出色的推理和agentic tool use能力。

kimi k2万亿规模参数量的训练主要得益于其在预训练阶段的几大技术创新:首先,自创的muonclip优化器实现15t token训练过程全程的高效稳定;自研的智能体模拟pipeline涵盖了数百场景数千工具,为模型在预训练阶段注入agentic tool use能力打下数据基础。

o3-pro

o3-pro是openai于6月10日发布的推理模型,针对科学、编程、写作等领域做了专门优化,在可靠性上也有明显的提升。相比前代具有更强大的推理能力,更容易生成符合人类偏好的回答。

o3-pro引入了更长的思考时间,适应于超长上下文(200k token的窗口)任务,展现出了出色的上下文理解和推理能力,与之而来的是简单问题的过度思考现象。

郑重声明:此文内容为本网站转载企业宣传资讯,目的在于传播更多信息,与本站立场无关。仅供读者参考,并请自行核实相关内容。